Технологии развиваются: на смену стали и дереву пришёл порох, на смену пороху пришло ядерное оружие — одна из самых страшных идей, когда-либо реализованных человечеством. Главный вооруженческий потенциал на сегодняшний день — это применение искусственного интеллекта и создание оружия с ним.

Наш автор Данил Степанов поговорил с Алимжаном Ахметовым, специалистом по разоружению и главному идеологу отказа от ИИ-оружия в Казахстане. Рассказываем, что это такое и какие перспективы борьбы с машинной угрозой существуют сегодня.

ЧТО ТАКОЕ ОРУЖИЕ С ИСКУССТВЕННЫМ ИНТЕЛЛЕКТОМ

Вы точно следите за развитием искусственного интеллекта, хотите вы этого или нет. Сейчас генеративные системы, вроде тех, что выпускает OpenAI и другие важные игроки рынка, активно внедряются в тысячи видов деятельности по всему миру. Их используют художники, заводы, полиция. Вполне очевидно, что на такую технологию обратили внимание военные и уже довольно давно.

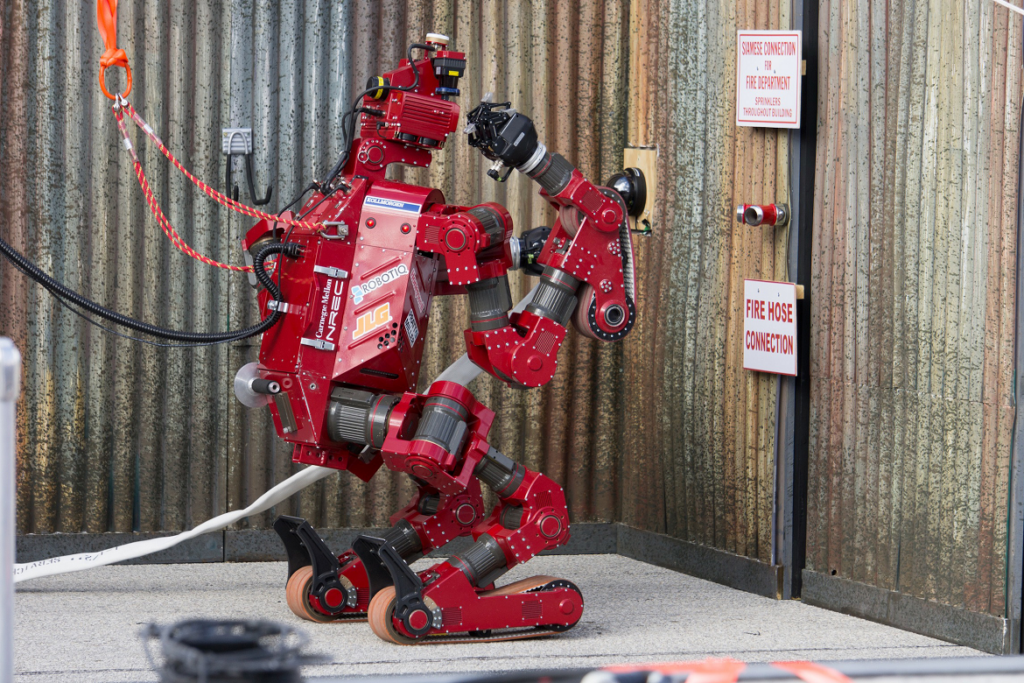

Искусственный интеллект в вооружениях на данный момент полностью не реализован. Существуют системы поиска и другие алгоритмы для решения военных задач, однако, ещё никто не предоставил полноценных боевых роботов. Однако такие разработки активно ведутся. Для военных новые технологии всегда были лакомым кусочком, но искусственный интеллект и вовсе позволит стороне, которая им обладает, свести свои потери к минимуму и превратить войну в исключительно экономическую гонку. Впереди всех в этом вопросе находятся страны, уже обладающие большим военным потенциалом — представители так называемого «ядерного клуба». США, Китай, Россия, Индия и несколько других государств.

Оружие с искусственным интеллектом, способное сражаться на поле боя — это самообучающиеся боевые системы, которые способны сражаться абсолютно без участия человека. И именно в этом состоит его опасность.

ПРОБЛЕМЫ ДОМИНАЦИИ

Когда я задал Алимжану вопрос о том, есть ли вероятность снижения потерь при помощи искусственного интеллекта, он посмеялся и сказал, что я использую аргумент Соединённых Штатов. Смысл этой мысли мне стал понятен только тогда, когда я начала глубже погружаться в тему вооружения с ИИ. Для наиболее богатых государств, больших игроков на мировой арене, которые постоянно ведут в разных точках мира вооружённые конфликты, введение в практику оружия с искусственным интеллектом действительно может стать способом снижения потерь.

Проблема состоит в том, что потери снизятся только с одной стороны — той, которая обладает новой технологией. Они получат намного большую выгоду, чем одно лишь снижение потерь. Им больше не придётся убеждать собственное население в «необходимости» конфликтов, не нужно будет превращать войну в нечто легитимное, не нужно будет заниматься призывом, отбором и подготовкой военных кадров. Всё будут делать роботы. Бедным же государствам останется роль жертвы: они будут терять население, обороноспособность и возможность для каких бы то ни было переговоров. Искусственный интеллект превращает войну из большого морального и этического вопроса в вопрос исключительно экономического характера.

«ЧЁРНЫЙ ЯЩИК»

Другой важный аспект появления такой технологии — это общая проблема всего искусственного интеллекта. Возможно, вы слышали, что иногда генеративные системы, как ChatGPT, называют «чёрным ящиком». Это означает, что нам известны только входные данные, которые получает ИИ, и выходная информация — в данном случае поведение боевой машины.

Алимжан рассказал, что важная проблема заключается в том, что мы не знаем, как именно и почему себя поведёт «солдат» с искусственным интеллектом. Если у человека есть какие-то внутренние ориентиры, собственные «стопы» и моральная проблема перед убийством человека, то алгоритмы этого полностью лишены. Будет ли робот отличать гражданских от военных? Сможет ли он избежать бессмысленной жестокости? Сохранит ли баланс между выполнением боевой задачи и соблюдением гуманистических принципов? Мы знаем, что и люди не всегда с этим справляются, но нечто о человеческой природе известно людям довольно хорошо, чего нельзя сказать об алгоритмах. Их поведение непредсказуемо из-за технической сложности систем машинного обучения, которые содержат в себе много миллиардов параметров.

НОРМАЛИЗАЦИЯ ВОЙНЫ

Некоторое время назад мне попалась интересная книга о войнах нового типа. Она называется «Теория дрона», её написал французский философ Грегуар Шамаю. Автор в тексте часто упоминал о важной этической проблеме: превращении войны в рутину. Если в обычных международных конфликтах их участники всегда взаимодействовали напрямую, то теперь появились методы, с помощью которых можно воевать, не выезжая из собственного города проживания.

Это превратило войну в nine-to-five работу, когда операторы дронов и других беспилотных летательных аппаратов занимаются ужасными вещами днём, а вечером спокойно возвращаются домой. Они не чувствуют угрозы для собственной жизни, не чувствуют моральной дилеммы перед убийством человека и очень плохо отличают военные цели от гражданских. Что в такие моменты происходит с психикой, и как это противоречие отражается не только на войне, но и на обычной, гражданской жизни самих операторов, только предстоит изучить.

В разговоре с Алимжаном я упомянул об этом, и он сказал, что дроны — предтеча оружия с искусственным интеллектом. У них есть общая проблема: и с использованием дронов, и с использованием искусственного интеллекта общество перестаёт ощущать, что находится в процессе военного конфликта. Люди в обычной жизни не чувствуют, что с их молчаливого согласия (или даже при частичном участии) где-то на другом конце планеты могут происходить ужасные вещи, а их государство несёт кому-то горе и разруху. Это — одна из причин, по которым любому обществу и любому государству стоит отказаться от оружия с ИИ, даже если оно не несёт для него угрозы напрямую.

ПРЕВЕНТИВНЫЕ МЕРЫ

Когда я поинтересовался, как обстоит вопрос с регулированием подобного оружия, Алимжан рассказал, что активные действия в этом направлении ведутся ещё с начала десятых годов. На проблему обращали внимание такие организации как ООН и Human Rights Watch, а ряд государств активно проталкивает превентивный запрет оружия с искусственным интеллектом.

Обсуждая с Алимжаном этот вопрос, мы пришли к выводу, что ситуация сходна с ядерным оружием, но лишь отчасти: все хорошо и заранее понимают, насколько опасно появление технологий, но пока дело не дойдёт до его применения или хотя бы испытаний, человечество может и не пошевелиться. Угроза ядерной катастрофы была огромна, но лишь после его применения появилась большая международная инициатива по запрету ядерного оружия и совместному разоружению стран-обладательниц. Не исключено, что нечто подобное ждёт и искусственный интеллект.

Однако главное, о чём говорил Алимжан, будучи директором НПО «Центр международной безопасности и политики», это низовые инициативы. С его точки зрения, важной проблемой является и тот факт, что государства уже давно обсуждают на дипломатическом уровне идею о запрете превентивного оружия с использованием искусственного интеллекта, но их низовая поддержка не очень велика. Если не учитывать НПО из передовых стран, то процесс выглядит совсем печально: именно поэтому он и создал свою организацию, одна из основных целей которой — это привлечение населения к обсуждению проблемы.

Государства могут договориться, создавать организации, занимающиеся контролем искусственного интеллекта. Но именно низовая инициатива, предложения, наблюдение за действиями стран и демократизация процесса обеспечат фундамент для будущей безопасности человечества перед лицом собственных технологий.

КАК НЕ ОСТАТЬСЯ В СТОРОНЕ?

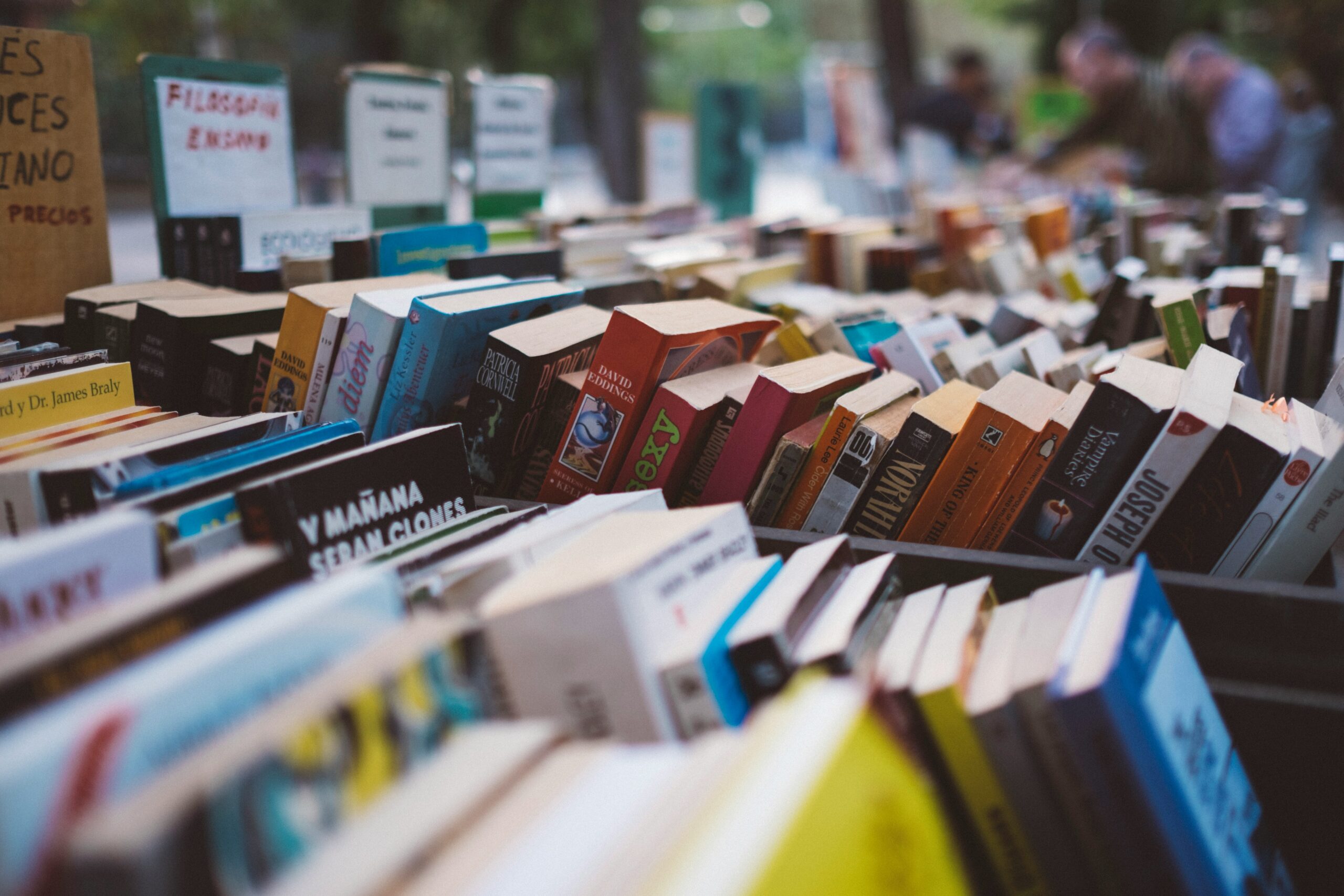

До разговора с Алимжаном я очень мало знал о том, что представляет собой оружие с ИИ, кто ведёт основные разработки и как военные конфликты могут выглядеть в будущем, если дело дойдёт до его использования. Я попросил его посоветовать что-то, с чем может ознакомиться сторонний человек, чтобы сложить правильное представление об угрозах и опасности автономного оружия. Конечно, лучше всего в качестве вводного материала можно послушать выступление самого Алимжана на Tedx.

Он рассказал мне об интересной книге Пола Шарра — «Army of None». Я только начал её читать, но уже могу сказать однозначно, что это одна из лучших возможных рекомендаций. Например, автор описывает ситуацию из войны в Афганистане. Он и его отряд увидели девочку дошкольного возраста, которая сообщала нечто по рации. Ни сам Шарр, ни кто-либо из его группы не посмел пойти на нечто столь ужасное, как выстрел в ребёнка.

Спустя годы размышлений вопрос Филипа Дика «Мечтают ли андроиды об электроовцах» превратился в голове автора в вопрос «Смог бы робот пожалеть ребёнка и пожертвовать тактической задачей ради невинной жизни?». Шарр ищет ответ именно на него. В этом исследовании он рассматривает, как будет выглядеть война будущего, и в ужасающих деталях даёт однозначное понимание — столь страшная технология требует немедленного запрета.

Именно к нему движется Алимжан Ахметов и его «Центр международной безопасности и политики».